言いたいこと

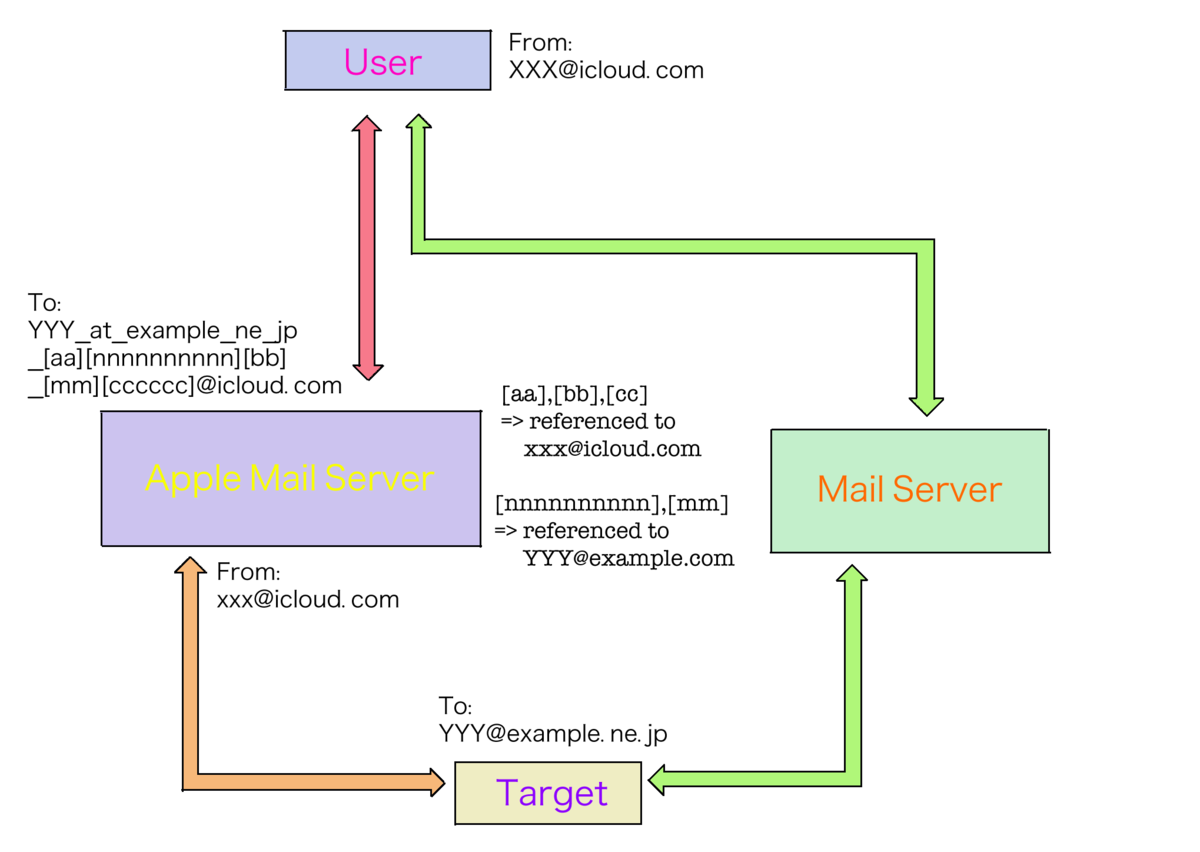

Apple iCloud+のPrivate Relayは擬似VPNとでも言えるような2段プロキシを採用していますが,

日本の東京エリアではAkamaiとCloudflareとFastlyの3社が分担でが出口プロキシを担当しているようで,

これは事前に出さたIPリストからwhoisすることで確認できます.

(本来は地域別のIPアドレス割り当ての対応表リストという役割がありますが,現状ではここ以外から通信することは不可能と思われる以上,これが実質的に出口プロキシのリストそのものになっています.)

同様にそのIPアドレスにnslookupを仕掛ければ,Akamaiサーバだけは

a[ppp-qqq-rrr-sss].deploy.static.akamaitechnologies.com

/* [ppp-qqq-rrr-sss] は出口プロキシが利用可能なipv4アドレス */

と解決ますが,CloudflareサーバとFastlyサーバではnxdomainを返されます.

1つの同じサービスにどのような理屈・過程で複数の仕様ができてしまったのか,その理由を知りたいと考えています.

特に一部のサービスではAkamaiサーバにのみ規制がかかっている (5ch.netのburned bbq:proxy(60)など) ため,

この (恐らくセキュリティ関係の) 設定の差が不便を生んだのではないかと疑っています.

加えて,Appleは出口プロキシのあり方についてどう考えているのか,DNSレコードに乗らないことをよしとしているのか,

または近い将来に仕様が統一されるかユーザーが選択できるか,といったことについても知れたら良いなと思っています.

おまけ

東京の出口プロキシのIPのリスト(CSV)を作ったよ!

一覧

172.224.240.128/27,Akamai

172.225.46.64/26,Akamai

172.225.46.208/28,Akamai

172.225.48.0/26,Akamai

172.225.48.128/28,Akamai

172.225.52.176/28,Akamai

172.225.54.128/26,Akamai

172.225.74.128/26,Akamai

172.225.75.0/24,Akamai

172.225.76.0/24,Akamai

172.225.122.0/25,Akamai

172.225.122.192/27,Akamai

172.225.123.0/25,Akamai

172.225.123.128/27,Akamai

172.225.124.192/27,Akamai

172.225.127.0/25,Akamai

172.226.24.0/25,Akamai

172.226.24.128/27,Akamai

172.226.42.0/25,Akamai

172.226.54.0/26,Akamai

172.226.54.64/28,Akamai

172.226.56.0/26,Akamai

172.226.56.64/28,Akamai

172.226.58.0/26,Akamai

172.226.58.64/28,Akamai

2a02:26f7:b980::/42,Akamai

104.28.0.45/32,Cloudflare

104.28.0.46/32,Cloudflare

104.28.4.73/32,Cloudflare

104.28.4.74/32,Cloudflare

104.28.44.37/32,Cloudflare

104.28.44.38/32,Cloudflare

104.28.44.39/32,Cloudflare

104.28.44.40/32,Cloudflare

104.28.44.41/32,Cloudflare

104.28.44.42/32,Cloudflare

104.28.44.43/32,Cloudflare

104.28.44.44/32,Cloudflare

104.28.44.45/32,Cloudflare

104.28.44.46/32,Cloudflare

104.28.44.47/32,Cloudflare

104.28.44.48/32,Cloudflare

104.28.44.49/32,Cloudflare

104.28.44.50/32,Cloudflare

104.28.44.51/32,Cloudflare

104.28.44.52/32,Cloudflare

104.28.44.53/32,Cloudflare

104.28.44.54/32,Cloudflare

104.28.44.55/32,Cloudflare

104.28.44.56/32,Cloudflare

104.28.44.57/32,Cloudflare

104.28.44.58/32,Cloudflare

104.28.44.59/32,Cloudflare

104.28.44.60/32,Cloudflare

104.28.44.61/32,Cloudflare

104.28.44.62/32,Cloudflare

104.28.44.63/32,Cloudflare

104.28.44.64/32,Cloudflare

104.28.44.65/32,Cloudflare

104.28.44.66/32,Cloudflare

104.28.44.67/32,Cloudflare

104.28.44.68/32,Cloudflare

104.28.44.69/32,Cloudflare

104.28.44.70/32,Cloudflare

104.28.44.71/32,Cloudflare

104.28.44.72/32,Cloudflare

104.28.44.73/32,Cloudflare

104.28.44.74/32,Cloudflare

104.28.67.170/32,Cloudflare

104.28.67.171/32,Cloudflare

104.28.67.172/32,Cloudflare

104.28.67.173/32,Cloudflare

104.28.67.174/32,Cloudflare

104.28.67.175/32,Cloudflare

104.28.67.176/32,Cloudflare

104.28.67.177/32,Cloudflare

104.28.67.178/32,Cloudflare

104.28.67.179/32,Cloudflare

104.28.67.180/32,Cloudflare

104.28.67.181/32,Cloudflare

104.28.67.182/32,Cloudflare

104.28.67.183/32,Cloudflare

104.28.67.184/32,Cloudflare

104.28.67.185/32,Cloudflare

104.28.67.186/32,Cloudflare

104.28.67.187/32,Cloudflare

104.28.67.188/32,Cloudflare

104.28.67.189/32,Cloudflare

104.28.67.190/32,Cloudflare

104.28.67.191/32,Cloudflare

104.28.67.192/32,Cloudflare

104.28.67.193/32,Cloudflare

104.28.67.194/32,Cloudflare

104.28.67.195/32,Cloudflare

104.28.67.196/32,Cloudflare

104.28.67.197/32,Cloudflare

104.28.67.198/32,Cloudflare

104.28.67.199/32,Cloudflare

104.28.67.200/32,Cloudflare

104.28.67.201/32,Cloudflare

104.28.67.202/32,Cloudflare

104.28.67.203/32,Cloudflare

104.28.67.204/32,Cloudflare

104.28.67.205/32,Cloudflare

104.28.67.206/32,Cloudflare

104.28.67.207/32,Cloudflare

104.28.70.170/32,Cloudflare

104.28.70.171/32,Cloudflare

104.28.70.172/32,Cloudflare

104.28.70.173/32,Cloudflare

104.28.70.174/32,Cloudflare

104.28.70.175/32,Cloudflare

104.28.70.176/32,Cloudflare

104.28.70.177/32,Cloudflare

104.28.70.178/32,Cloudflare

104.28.70.179/32,Cloudflare

104.28.70.180/32,Cloudflare

104.28.70.181/32,Cloudflare

104.28.70.182/32,Cloudflare

104.28.70.183/32,Cloudflare

104.28.70.184/32,Cloudflare

104.28.70.185/32,Cloudflare

104.28.70.186/32,Cloudflare

104.28.70.187/32,Cloudflare

104.28.70.188/32,Cloudflare

104.28.70.189/32,Cloudflare

104.28.70.190/32,Cloudflare

104.28.70.191/32,Cloudflare

104.28.70.192/32,Cloudflare

104.28.70.193/32,Cloudflare

104.28.70.194/32,Cloudflare

104.28.70.195/32,Cloudflare

104.28.70.196/32,Cloudflare

104.28.70.197/32,Cloudflare

104.28.70.198/32,Cloudflare

104.28.70.199/32,Cloudflare

104.28.70.200/32,Cloudflare

104.28.70.201/32,Cloudflare

104.28.70.202/32,Cloudflare

104.28.70.203/32,Cloudflare

104.28.70.204/32,Cloudflare

104.28.70.205/32,Cloudflare

104.28.70.206/32,Cloudflare

104.28.70.207/32,Cloudflare

104.28.83.195/32,Cloudflare

104.28.83.196/32,Cloudflare

104.28.83.197/32,Cloudflare

104.28.83.198/32,Cloudflare

104.28.83.199/32,Cloudflare

104.28.83.200/32,Cloudflare

104.28.83.201/32,Cloudflare

104.28.83.202/32,Cloudflare

104.28.83.203/32,Cloudflare

104.28.83.204/32,Cloudflare

104.28.83.205/32,Cloudflare

104.28.83.206/32,Cloudflare

104.28.83.207/32,Cloudflare

104.28.83.208/32,Cloudflare

104.28.83.209/32,Cloudflare

104.28.83.210/32,Cloudflare

104.28.83.211/32,Cloudflare

104.28.83.212/32,Cloudflare

104.28.83.213/32,Cloudflare

104.28.83.214/32,Cloudflare

104.28.83.215/32,Cloudflare

104.28.83.216/32,Cloudflare

104.28.83.217/32,Cloudflare

104.28.83.218/32,Cloudflare

104.28.83.219/32,Cloudflare

104.28.83.220/32,Cloudflare

104.28.83.221/32,Cloudflare

104.28.83.222/32,Cloudflare

104.28.83.223/32,Cloudflare

104.28.83.224/32,Cloudflare

104.28.83.225/32,Cloudflare

104.28.83.226/32,Cloudflare

104.28.83.227/32,Cloudflare

104.28.83.228/32,Cloudflare

104.28.83.229/32,Cloudflare

104.28.83.230/32,Cloudflare

104.28.83.231/32,Cloudflare

104.28.83.232/32,Cloudflare

104.28.99.191/32,Cloudflare

104.28.99.192/32,Cloudflare

104.28.99.193/32,Cloudflare

104.28.99.194/32,Cloudflare

104.28.99.195/32,Cloudflare

104.28.99.196/32,Cloudflare

104.28.99.197/32,Cloudflare

104.28.99.198/32,Cloudflare

104.28.99.199/32,Cloudflare

104.28.99.200/32,Cloudflare

104.28.99.201/32,Cloudflare

104.28.99.202/32,Cloudflare

104.28.99.203/32,Cloudflare

104.28.99.204/32,Cloudflare

104.28.99.205/32,Cloudflare

104.28.99.206/32,Cloudflare

104.28.99.207/32,Cloudflare

104.28.99.208/32,Cloudflare

104.28.99.209/32,Cloudflare

104.28.99.210/32,Cloudflare

104.28.99.211/32,Cloudflare

104.28.99.212/32,Cloudflare

104.28.99.213/32,Cloudflare

104.28.99.214/32,Cloudflare

104.28.99.215/32,Cloudflare

104.28.99.216/32,Cloudflare

104.28.99.217/32,Cloudflare

104.28.99.218/32,Cloudflare

104.28.99.219/32,Cloudflare

104.28.99.220/32,Cloudflare

104.28.99.221/32,Cloudflare

104.28.99.222/32,Cloudflare

104.28.99.223/32,Cloudflare

104.28.99.224/32,Cloudflare

104.28.99.225/32,Cloudflare

104.28.99.226/32,Cloudflare

104.28.99.227/32,Cloudflare

104.28.99.228/32,Cloudflare

104.28.101.191/32,Cloudflare

104.28.101.192/32,Cloudflare

104.28.101.193/32,Cloudflare

104.28.101.194/32,Cloudflare

104.28.101.195/32,Cloudflare

104.28.101.196/32,Cloudflare

104.28.101.197/32,Cloudflare

104.28.101.198/32,Cloudflare

104.28.101.199/32,Cloudflare

104.28.101.200/32,Cloudflare

104.28.101.201/32,Cloudflare

104.28.101.202/32,Cloudflare

104.28.101.203/32,Cloudflare

104.28.101.204/32,Cloudflare

104.28.101.205/32,Cloudflare

104.28.101.206/32,Cloudflare

104.28.101.207/32,Cloudflare

104.28.101.208/32,Cloudflare

104.28.101.209/32,Cloudflare

104.28.101.210/32,Cloudflare

104.28.101.211/32,Cloudflare

104.28.101.212/32,Cloudflare

104.28.101.213/32,Cloudflare

104.28.101.214/32,Cloudflare

104.28.101.215/32,Cloudflare

104.28.101.216/32,Cloudflare

104.28.101.217/32,Cloudflare

104.28.101.218/32,Cloudflare

104.28.101.219/32,Cloudflare

104.28.101.220/32,Cloudflare

104.28.101.221/32,Cloudflare

104.28.101.222/32,Cloudflare

104.28.101.223/32,Cloudflare

104.28.101.224/32,Cloudflare

104.28.101.225/32,Cloudflare

104.28.101.226/32,Cloudflare

104.28.101.227/32,Cloudflare

104.28.101.228/32,Cloudflare

104.28.118.164/32,Cloudflare

104.28.118.165/32,Cloudflare

104.28.118.166/32,Cloudflare

104.28.118.167/32,Cloudflare

104.28.118.168/32,Cloudflare

104.28.118.169/32,Cloudflare

104.28.118.170/32,Cloudflare

104.28.118.171/32,Cloudflare

104.28.118.172/32,Cloudflare

104.28.118.173/32,Cloudflare

104.28.118.174/32,Cloudflare

104.28.118.175/32,Cloudflare

104.28.118.176/32,Cloudflare

104.28.118.177/32,Cloudflare

104.28.118.178/32,Cloudflare

104.28.118.179/32,Cloudflare

104.28.118.180/32,Cloudflare

104.28.118.181/32,Cloudflare

104.28.118.182/32,Cloudflare

104.28.118.183/32,Cloudflare

104.28.118.184/32,Cloudflare

104.28.118.185/32,Cloudflare

104.28.118.186/32,Cloudflare

104.28.118.187/32,Cloudflare

104.28.118.188/32,Cloudflare

104.28.118.189/32,Cloudflare

104.28.118.190/32,Cloudflare

104.28.118.191/32,Cloudflare

104.28.118.192/32,Cloudflare

104.28.118.193/32,Cloudflare

104.28.118.194/32,Cloudflare

104.28.118.195/32,Cloudflare

104.28.118.196/32,Cloudflare

104.28.118.197/32,Cloudflare

104.28.118.198/32,Cloudflare

104.28.118.199/32,Cloudflare

104.28.118.200/32,Cloudflare

104.28.118.201/32,Cloudflare

104.28.121.164/32,Cloudflare

104.28.121.165/32,Cloudflare

104.28.121.166/32,Cloudflare

104.28.121.167/32,Cloudflare

104.28.121.168/32,Cloudflare

104.28.121.169/32,Cloudflare

104.28.121.170/32,Cloudflare

104.28.121.171/32,Cloudflare

104.28.121.172/32,Cloudflare

104.28.121.173/32,Cloudflare

104.28.121.174/32,Cloudflare

104.28.121.175/32,Cloudflare

104.28.121.176/32,Cloudflare

104.28.121.177/32,Cloudflare

104.28.121.178/32,Cloudflare

104.28.121.179/32,Cloudflare

104.28.121.180/32,Cloudflare

104.28.121.181/32,Cloudflare

104.28.121.182/32,Cloudflare

104.28.121.183/32,Cloudflare

104.28.121.184/32,Cloudflare

104.28.121.185/32,Cloudflare

104.28.121.186/32,Cloudflare

104.28.121.187/32,Cloudflare

104.28.121.188/32,Cloudflare

104.28.121.189/32,Cloudflare

104.28.121.190/32,Cloudflare

104.28.121.191/32,Cloudflare

104.28.121.192/32,Cloudflare

104.28.121.193/32,Cloudflare

104.28.121.194/32,Cloudflare

104.28.121.195/32,Cloudflare

104.28.121.196/32,Cloudflare

104.28.121.197/32,Cloudflare

104.28.121.198/32,Cloudflare

104.28.121.199/32,Cloudflare

104.28.121.200/32,Cloudflare

104.28.121.201/32,Cloudflare

2606:54c0:3b00:10::/64,Cloudflare

2606:54c0:3b00:128::/64,Cloudflare

2606:54c0:3b20:10::/64,Cloudflare

2606:54c0:3b20:128::/64,Cloudflare

2606:54c0:3b40:10::/64,Cloudflare

2606:54c0:3b40:128::/64,Cloudflare

2606:54c0:3b60:10::/64,Cloudflare

104.28.0.45/33,Cloudflare

146.75.189.22/31,Fastly

2a04:4e41:0029:000b::/64,Fastly

146.75.196.14/31,Fastly

2a04:4e41:0030:0007::/64,Fastly

146.75.201.12/31,Fastly

2a04:4e41:0035:0006::/64,Fastly

みんなも試してみよう!

原文

Akamai vs Cloudflare vs Fastly : whether Egress Proxy (on Private Relay) are NXDOMAIN

In my country (Tokyo, Japan), it seems like that

"Akamai Technologies, Inc.", "Cloudflare, Inc.", and "Fastly, Inc.",

are providing almost all the egress proxy for using Private Relay (and these are estimated by whois information).

Also I was able to resolve the domain of Akamai's egress proxy with nslookup, such as:

a[ppp-qqq-rrr-sss].deploy.static.akamaitechnologies.com

/* [ppp-qqq-rrr-sss] means available ipv4 address of egress proxy */

but I couldn't resolve Cloudflare's and Fastly's, with NXDOMAIN error.

I want to know how and why has this difference occurred between Cloudflare, Fastly and Akamai, still it's one and the same service.

Because I found that some web services limit the use for accesses from Akami's Egress Proxy only, thus I'm guessing that this difference (security settings?) is causing the inconvenience.

In addition, I would like to know if Apple is comfortable with the situation of egress proxy not in the DNS records. And I hope that near the future either specification would be standardized or users would be able to choose them.

By the way, I might be often assigned the following IP addresses:

the list

172.224.240.128/27,Akamai

172.225.46.64/26,Akamai

172.225.46.208/28,Akamai

172.225.48.0/26,Akamai

172.225.48.128/28,Akamai

172.225.52.176/28,Akamai

172.225.54.128/26,Akamai

172.225.74.128/26,Akamai

172.225.75.0/24,Akamai

172.225.76.0/24,Akamai

172.225.122.0/25,Akamai

172.225.122.192/27,Akamai

172.225.123.0/25,Akamai

172.225.123.128/27,Akamai

172.225.124.192/27,Akamai

172.225.127.0/25,Akamai

172.226.24.0/25,Akamai

172.226.24.128/27,Akamai

172.226.42.0/25,Akamai

172.226.54.0/26,Akamai

172.226.54.64/28,Akamai

172.226.56.0/26,Akamai

172.226.56.64/28,Akamai

172.226.58.0/26,Akamai

172.226.58.64/28,Akamai

2a02:26f7:b980::/42,Akamai

104.28.0.45/32,Cloudflare

104.28.0.46/32,Cloudflare

104.28.4.73/32,Cloudflare

104.28.4.74/32,Cloudflare

104.28.44.37/32,Cloudflare

104.28.44.38/32,Cloudflare

104.28.44.39/32,Cloudflare

104.28.44.40/32,Cloudflare

104.28.44.41/32,Cloudflare

104.28.44.42/32,Cloudflare

104.28.44.43/32,Cloudflare

104.28.44.44/32,Cloudflare

104.28.44.45/32,Cloudflare

104.28.44.46/32,Cloudflare

104.28.44.47/32,Cloudflare

104.28.44.48/32,Cloudflare

104.28.44.49/32,Cloudflare

104.28.44.50/32,Cloudflare

104.28.44.51/32,Cloudflare

104.28.44.52/32,Cloudflare

104.28.44.53/32,Cloudflare

104.28.44.54/32,Cloudflare

104.28.44.55/32,Cloudflare

104.28.44.56/32,Cloudflare

104.28.44.57/32,Cloudflare

104.28.44.58/32,Cloudflare

104.28.44.59/32,Cloudflare

104.28.44.60/32,Cloudflare

104.28.44.61/32,Cloudflare

104.28.44.62/32,Cloudflare

104.28.44.63/32,Cloudflare

104.28.44.64/32,Cloudflare

104.28.44.65/32,Cloudflare

104.28.44.66/32,Cloudflare

104.28.44.67/32,Cloudflare

104.28.44.68/32,Cloudflare

104.28.44.69/32,Cloudflare

104.28.44.70/32,Cloudflare

104.28.44.71/32,Cloudflare

104.28.44.72/32,Cloudflare

104.28.44.73/32,Cloudflare

104.28.44.74/32,Cloudflare

104.28.67.170/32,Cloudflare

104.28.67.171/32,Cloudflare

104.28.67.172/32,Cloudflare

104.28.67.173/32,Cloudflare

104.28.67.174/32,Cloudflare

104.28.67.175/32,Cloudflare

104.28.67.176/32,Cloudflare

104.28.67.177/32,Cloudflare

104.28.67.178/32,Cloudflare

104.28.67.179/32,Cloudflare

104.28.67.180/32,Cloudflare

104.28.67.181/32,Cloudflare

104.28.67.182/32,Cloudflare

104.28.67.183/32,Cloudflare

104.28.67.184/32,Cloudflare

104.28.67.185/32,Cloudflare

104.28.67.186/32,Cloudflare

104.28.67.187/32,Cloudflare

104.28.67.188/32,Cloudflare

104.28.67.189/32,Cloudflare

104.28.67.190/32,Cloudflare

104.28.67.191/32,Cloudflare

104.28.67.192/32,Cloudflare

104.28.67.193/32,Cloudflare

104.28.67.194/32,Cloudflare

104.28.67.195/32,Cloudflare

104.28.67.196/32,Cloudflare

104.28.67.197/32,Cloudflare

104.28.67.198/32,Cloudflare

104.28.67.199/32,Cloudflare

104.28.67.200/32,Cloudflare

104.28.67.201/32,Cloudflare

104.28.67.202/32,Cloudflare

104.28.67.203/32,Cloudflare

104.28.67.204/32,Cloudflare

104.28.67.205/32,Cloudflare

104.28.67.206/32,Cloudflare

104.28.67.207/32,Cloudflare

104.28.70.170/32,Cloudflare

104.28.70.171/32,Cloudflare

104.28.70.172/32,Cloudflare

104.28.70.173/32,Cloudflare

104.28.70.174/32,Cloudflare

104.28.70.175/32,Cloudflare

104.28.70.176/32,Cloudflare

104.28.70.177/32,Cloudflare

104.28.70.178/32,Cloudflare

104.28.70.179/32,Cloudflare

104.28.70.180/32,Cloudflare

104.28.70.181/32,Cloudflare

104.28.70.182/32,Cloudflare

104.28.70.183/32,Cloudflare

104.28.70.184/32,Cloudflare

104.28.70.185/32,Cloudflare

104.28.70.186/32,Cloudflare

104.28.70.187/32,Cloudflare

104.28.70.188/32,Cloudflare

104.28.70.189/32,Cloudflare

104.28.70.190/32,Cloudflare

104.28.70.191/32,Cloudflare

104.28.70.192/32,Cloudflare

104.28.70.193/32,Cloudflare

104.28.70.194/32,Cloudflare

104.28.70.195/32,Cloudflare

104.28.70.196/32,Cloudflare

104.28.70.197/32,Cloudflare

104.28.70.198/32,Cloudflare

104.28.70.199/32,Cloudflare

104.28.70.200/32,Cloudflare

104.28.70.201/32,Cloudflare

104.28.70.202/32,Cloudflare

104.28.70.203/32,Cloudflare

104.28.70.204/32,Cloudflare

104.28.70.205/32,Cloudflare

104.28.70.206/32,Cloudflare

104.28.70.207/32,Cloudflare

104.28.83.195/32,Cloudflare

104.28.83.196/32,Cloudflare

104.28.83.197/32,Cloudflare

104.28.83.198/32,Cloudflare

104.28.83.199/32,Cloudflare

104.28.83.200/32,Cloudflare

104.28.83.201/32,Cloudflare

104.28.83.202/32,Cloudflare

104.28.83.203/32,Cloudflare

104.28.83.204/32,Cloudflare

104.28.83.205/32,Cloudflare

104.28.83.206/32,Cloudflare

104.28.83.207/32,Cloudflare

104.28.83.208/32,Cloudflare

104.28.83.209/32,Cloudflare

104.28.83.210/32,Cloudflare

104.28.83.211/32,Cloudflare

104.28.83.212/32,Cloudflare

104.28.83.213/32,Cloudflare

104.28.83.214/32,Cloudflare

104.28.83.215/32,Cloudflare

104.28.83.216/32,Cloudflare

104.28.83.217/32,Cloudflare

104.28.83.218/32,Cloudflare

104.28.83.219/32,Cloudflare

104.28.83.220/32,Cloudflare

104.28.83.221/32,Cloudflare

104.28.83.222/32,Cloudflare

104.28.83.223/32,Cloudflare

104.28.83.224/32,Cloudflare

104.28.83.225/32,Cloudflare

104.28.83.226/32,Cloudflare

104.28.83.227/32,Cloudflare

104.28.83.228/32,Cloudflare

104.28.83.229/32,Cloudflare

104.28.83.230/32,Cloudflare

104.28.83.231/32,Cloudflare

104.28.83.232/32,Cloudflare

104.28.99.191/32,Cloudflare

104.28.99.192/32,Cloudflare

104.28.99.193/32,Cloudflare

104.28.99.194/32,Cloudflare

104.28.99.195/32,Cloudflare

104.28.99.196/32,Cloudflare

104.28.99.197/32,Cloudflare

104.28.99.198/32,Cloudflare

104.28.99.199/32,Cloudflare

104.28.99.200/32,Cloudflare

104.28.99.201/32,Cloudflare

104.28.99.202/32,Cloudflare

104.28.99.203/32,Cloudflare

104.28.99.204/32,Cloudflare

104.28.99.205/32,Cloudflare

104.28.99.206/32,Cloudflare

104.28.99.207/32,Cloudflare

104.28.99.208/32,Cloudflare

104.28.99.209/32,Cloudflare

104.28.99.210/32,Cloudflare

104.28.99.211/32,Cloudflare

104.28.99.212/32,Cloudflare

104.28.99.213/32,Cloudflare

104.28.99.214/32,Cloudflare

104.28.99.215/32,Cloudflare

104.28.99.216/32,Cloudflare

104.28.99.217/32,Cloudflare

104.28.99.218/32,Cloudflare

104.28.99.219/32,Cloudflare

104.28.99.220/32,Cloudflare

104.28.99.221/32,Cloudflare

104.28.99.222/32,Cloudflare

104.28.99.223/32,Cloudflare

104.28.99.224/32,Cloudflare

104.28.99.225/32,Cloudflare

104.28.99.226/32,Cloudflare

104.28.99.227/32,Cloudflare

104.28.99.228/32,Cloudflare

104.28.101.191/32,Cloudflare

104.28.101.192/32,Cloudflare

104.28.101.193/32,Cloudflare

104.28.101.194/32,Cloudflare

104.28.101.195/32,Cloudflare

104.28.101.196/32,Cloudflare

104.28.101.197/32,Cloudflare

104.28.101.198/32,Cloudflare

104.28.101.199/32,Cloudflare

104.28.101.200/32,Cloudflare

104.28.101.201/32,Cloudflare

104.28.101.202/32,Cloudflare

104.28.101.203/32,Cloudflare

104.28.101.204/32,Cloudflare

104.28.101.205/32,Cloudflare

104.28.101.206/32,Cloudflare

104.28.101.207/32,Cloudflare

104.28.101.208/32,Cloudflare

104.28.101.209/32,Cloudflare

104.28.101.210/32,Cloudflare

104.28.101.211/32,Cloudflare

104.28.101.212/32,Cloudflare

104.28.101.213/32,Cloudflare

104.28.101.214/32,Cloudflare

104.28.101.215/32,Cloudflare

104.28.101.216/32,Cloudflare

104.28.101.217/32,Cloudflare

104.28.101.218/32,Cloudflare

104.28.101.219/32,Cloudflare

104.28.101.220/32,Cloudflare

104.28.101.221/32,Cloudflare

104.28.101.222/32,Cloudflare

104.28.101.223/32,Cloudflare

104.28.101.224/32,Cloudflare

104.28.101.225/32,Cloudflare

104.28.101.226/32,Cloudflare

104.28.101.227/32,Cloudflare

104.28.101.228/32,Cloudflare

104.28.118.164/32,Cloudflare

104.28.118.165/32,Cloudflare

104.28.118.166/32,Cloudflare

104.28.118.167/32,Cloudflare

104.28.118.168/32,Cloudflare

104.28.118.169/32,Cloudflare

104.28.118.170/32,Cloudflare

104.28.118.171/32,Cloudflare

104.28.118.172/32,Cloudflare

104.28.118.173/32,Cloudflare

104.28.118.174/32,Cloudflare

104.28.118.175/32,Cloudflare

104.28.118.176/32,Cloudflare

104.28.118.177/32,Cloudflare

104.28.118.178/32,Cloudflare

104.28.118.179/32,Cloudflare

104.28.118.180/32,Cloudflare

104.28.118.181/32,Cloudflare

104.28.118.182/32,Cloudflare

104.28.118.183/32,Cloudflare

104.28.118.184/32,Cloudflare

104.28.118.185/32,Cloudflare

104.28.118.186/32,Cloudflare

104.28.118.187/32,Cloudflare

104.28.118.188/32,Cloudflare

104.28.118.189/32,Cloudflare

104.28.118.190/32,Cloudflare

104.28.118.191/32,Cloudflare

104.28.118.192/32,Cloudflare

104.28.118.193/32,Cloudflare

104.28.118.194/32,Cloudflare

104.28.118.195/32,Cloudflare

104.28.118.196/32,Cloudflare

104.28.118.197/32,Cloudflare

104.28.118.198/32,Cloudflare

104.28.118.199/32,Cloudflare

104.28.118.200/32,Cloudflare

104.28.118.201/32,Cloudflare

104.28.121.164/32,Cloudflare

104.28.121.165/32,Cloudflare

104.28.121.166/32,Cloudflare

104.28.121.167/32,Cloudflare

104.28.121.168/32,Cloudflare

104.28.121.169/32,Cloudflare

104.28.121.170/32,Cloudflare

104.28.121.171/32,Cloudflare

104.28.121.172/32,Cloudflare

104.28.121.173/32,Cloudflare

104.28.121.174/32,Cloudflare

104.28.121.175/32,Cloudflare

104.28.121.176/32,Cloudflare

104.28.121.177/32,Cloudflare

104.28.121.178/32,Cloudflare

104.28.121.179/32,Cloudflare

104.28.121.180/32,Cloudflare

104.28.121.181/32,Cloudflare

104.28.121.182/32,Cloudflare

104.28.121.183/32,Cloudflare

104.28.121.184/32,Cloudflare

104.28.121.185/32,Cloudflare

104.28.121.186/32,Cloudflare

104.28.121.187/32,Cloudflare

104.28.121.188/32,Cloudflare

104.28.121.189/32,Cloudflare

104.28.121.190/32,Cloudflare

104.28.121.191/32,Cloudflare

104.28.121.192/32,Cloudflare

104.28.121.193/32,Cloudflare

104.28.121.194/32,Cloudflare

104.28.121.195/32,Cloudflare

104.28.121.196/32,Cloudflare

104.28.121.197/32,Cloudflare

104.28.121.198/32,Cloudflare

104.28.121.199/32,Cloudflare

104.28.121.200/32,Cloudflare

104.28.121.201/32,Cloudflare

2606:54c0:3b00:10::/64,Cloudflare

2606:54c0:3b00:128::/64,Cloudflare

2606:54c0:3b20:10::/64,Cloudflare

2606:54c0:3b20:128::/64,Cloudflare

2606:54c0:3b40:10::/64,Cloudflare

2606:54c0:3b40:128::/64,Cloudflare

2606:54c0:3b60:10::/64,Cloudflare

104.28.0.45/33,Cloudflare

146.75.189.22/31,Fastly

2a04:4e41:0029:000b::/64,Fastly

146.75.196.14/31,Fastly

2a04:4e41:0030:0007::/64,Fastly

146.75.201.12/31,Fastly

2a04:4e41:0035:0006::/64,Fastly

so now you can check it.